Zarys historii informatyki

Ta praca została zatwierdzona przez naszego nauczyciela: 27.09.2024 o 16:28

Rodzaj zadania: Esej

Dodane: 25.09.2024 o 11:55

Streszczenie:

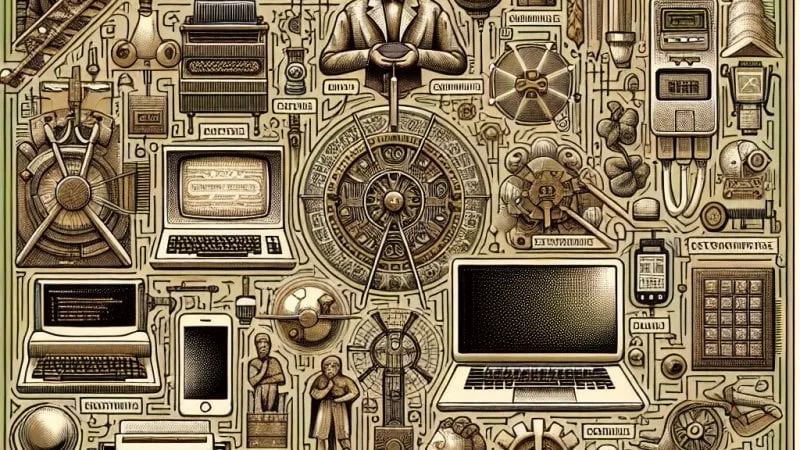

Historia informatyki to dynamiczny rozwój od mechanicznych maszyn po sztuczną inteligencję, rewolucjonizujący komunikację, przemysł i codzienne życie. ??

Historia informatyki, choć stosunkowo młoda w porównaniu z innymi dziedzinami nauki, jest niezwykle bogata i dynamiczna. Rozwój technologii informatycznych miał ogromny wpływ na kształtowanie współczesnego świata, a zrozumienie jego historii pozwala lepiej docenić dokonania naukowców i inżynierów, które zrewolucjonizowały komunikację, przemysł, naukę i rozrywkę. Prześledźmy więc, jak ta fascynująca dziedzina rozwijała się na przestrzeni wieków, od pierwszych mechanicznych maszyn obliczeniowych po współczesne komputery o ogromnej mocy obliczeniowej i zdolności do sztucznej inteligencji.

Początki informatyki: Od mechanicznych kalkulatorów do maszyn analitycznych

Początki informatyki można datować na moment powstania pierwszych maszyn obliczeniowych. W XVII wieku niemiecki matematyk i filozof Gottfried Wilhelm Leibniz wynalazł mechaniczny kalkulator, który był zdolny do wykonywania podstawowych operacji arytmetycznych, takich jak dodawanie, odejmowanie, mnożenie i dzielenie. Jego prace zainspirowały późniejszych wynalazców oraz stanowiły podstawę dla dalszych badań nad mechanizacją obliczeń.W XIX wieku brytyjski matematyk Charles Babbage stworzył projekt maszyny analitycznej – teoretyczne urządzenie do wykonywania dowolnych obliczeń arytmetycznych. Maszyna analityczna Babbage’a była potężnym przełomem koncepcyjnym, który choć nigdy nie została w całości zrealizowana, jest powszechnie uznawana za prekursora współczesnych komputerów. Babbage przewidział możliwość zastosowania kart perforacyjnych do sterowania operacjami maszyny, co było pierwszym krokiem w kierunku automatyzacji procesów obliczeniowych.

Równie ważnym wkładem w rozwój informatyki była działalność Ady Lovelace, którą często nazywa się pierwszą programistką. Lovelace, współpracując z Babbagem, napisała szczegółowe opisy algorytmów, które miały być wykonane przez maszynę analityczną. Jej prace, choć długo niedoceniane, pokazały, że komputery mogą być programowane do wykonywania różnorodnych zadań, a nie tylko prostych obliczeń – co stanowiło znaczący krok w kierunku współczesnego oprogramowania.

Era komputerów mechanicznych i elektronicznych: Przełom XX wieku

W XX wieku rozwój elektroniki i telekomunikacji zapoczątkował erę informatyki cyfrowej. W latach 30. XX wieku brytyjski matematyk Alan Turing wprowadził koncept maszyny Turinga – abstrakcyjnego urządzenia, które może wykonywać dowolny algorytm, jeśli jest on matematycznie sformułowany. Machina Turinga stała się kluczowym modelem teoretycznym dla późniejszych komputerów i podstawą teorii obliczeń.Podczas II wojny światowej intensywne prace nad maszynami obliczeniowymi były prowadzone na potrzeby kryptografii i analizy danych wojskowych. W Stanach Zjednoczonych zbudowano pierwsze elektroniczne komputery, takie jak ENIAC (Electronic Numerical Integrator and Computer), które były w stanie wykonywać skomplikowane obliczenia z prędkością niedostępną dla wcześniejszych mechanicznych urządzeń.

ENIAC, ukończony w 1945 roku, był pierwszym programowalnym, elektronicznym, wielozadaniowym komputerem cyfrowym. Zastosowanie w nim lamp próżniowych umożliwiło osiągnięcie znacznej mocy obliczeniowej, co miało ogromne znaczenie praktyczne, zwłaszcza w kontekście obliczeń wymaganych przez projekty wojskowe. ENIAC był w stanie wykonywać operacje z szybkością nieosiągalną dla swoich mechanicznych poprzedników, otwierając tym samym nową erę w historii informatyki.

Lata 50. i 60.: Narodziny języków programowania i miniaturyzacja

Lata 50. i 60. XX wieku to okres ogromnych postępów technologicznych i wzmocnienia fundamentów informatyki jako odrębnej dziedziny nauki. Rozwój języków programowania, takich jak Fortran (stworzonego przez Johna Backusa i jego zespół w 1957 roku), Cobol oraz Algol, znacznie przyczynił się do powszechnego wykorzystania komputerów w nauce, przemyśle i administracji. Języki te ułatwiły tworzenie i zarządzanie skomplikowanymi programami, co z kolei umożliwiło dalszy rozwój oprogramowania i aplikacji komputerowych.W tym czasie także tranzystor, wynaleziony przez zespół w składzie: William Shockley, John Bardeen oraz Walter Brattain w Bell Laboratories w 1947 roku, zrewolucjonizował konstrukcję komputerów. Tranzystory zastąpiły lampy próżniowe, co pozwoliło na budowę mniejszych, szybszych i bardziej niezawodnych urządzeń. Pierwsze komputery tranzystorowe pojawiły się w latach 60., a ich miniaturyzacja stała się kluczowym czynnikiem napędzającym dalszy rozwój technologii komputerowej.

Mikroprocesory i narodziny komputerów osobistych

Kolejnym przełomem w technologii komputerowej było wprowadzenie mikroprocesora w latach 70. Mikroprocesor to zintegrowany układ scalony, który zawiera całą jednostkę centralną komputera na jednej krzemowej płytce. Pierwszy mikroprocesor, Intel 4004, został wyprodukowany przez firmę Intel w 1971 roku. Zintegrowanie wszystkich funkcji centralnego procesora w jednym układzie scalonym umożliwiło budowę znacznie mniejszych i tańszych komputerów, co otworzyło drogę do rozwoju komputeryzacji na szeroką skalę.W 1977 roku Apple Inc. wprowadziło na rynek Apple II, jeden z pierwszych komputerów osobistych przeznaczonych dla masowego odbiorcy. W 1981 roku IBM zaprezentował IBM PC, który stał się standardem w świecie komputerów osobistych. Te komputery, wyposażone w mikroprocesory, pamięć i nośniki danych, stały się dostępne dla szerokiej rzeszy użytkowników, co zainicjowało erę informatyki personalnej. Komputery te znalazły zastosowanie nie tylko w biurach i instytucjach, ale także w domach, szkołach i małych firmach, rewolucjonizując codzienne życie i pracę milionów ludzi.

Lata 80. i 90.: Wielki rozwój software i sieci komputerowych

Lata 80. i 90. były czasem spektakularnego rozwoju oprogramowania i sieci komputerowych. Wprowadzono systemy operacyjne, takie jak MS-DOS, który stał się podstawą dla komputerów IBM, oraz później Microsoft Windows, który zdominował rynek komputerów osobistych. Systemy te ułatwiały korzystanie z komputerów, zwiększając ich dostępność i funkcjonalność. Powstanie oprogramowania użytkowego, takiego jak arkusze kalkulacyjne, edytory tekstu i bazy danych, przyspieszyło proces komputeryzacji w różnych sektorach gospodarki.W tych dekadach powstała również koncepcja Internetu, co było efektem badań nad sieciami komputerowymi prowadzonych między innymi przez amerykańską agencję ARPA (Advanced Research Projects Agency). W latach 60. rozpoczęto projekt ARPANET, którego celem było stworzenie sieci rozproszonych komputerów mogących komunikować się ze sobą w sposób niezawodny i szybki. W 1983 roku ARPANET wykorzystał protokół TCP/IP, który stał się standardem komunikacji w sieciach komputerowych i fundamentem współczesnego Internetu.

Rok 1989 przyniósł kolejny przełom w historii informatyki, gdy Tim Berners-Lee, naukowiec w Europejskiej Organizacji Badań Jądrowych (CERN), stworzył World Wide Web (WWW). WWW umożliwił wygodny dostęp do informacji na globalną skalę, przekształcając Internet w sieć, którą możemy dzisiaj przeglądać za pomocą przeglądarek internetowych. Wprowadzenie internetu w latach 90. przyniosło do domów i biur ogromne zasoby informacji oraz nowe formy komunikacji, takie jak poczta elektroniczna, czaty i fora dyskusyjne.

XXI wiek: Technologia mobilna, chmura obliczeniowa i sztuczna inteligencja

Najnowsza historia informatyki to niezwykle dynamiczny rozwój technologii mobilnych, chmur obliczeniowych, sztucznej inteligencji i Internetu Rzeczy (IoT). Począwszy od lat 2000, gwałtowny rozwój telefonów komórkowych przekształcił je w urządzenia wielofunkcyjne, zdolne do wykonywania zadań komputerowych. Wprowadzenie smartfonów, takich jak iPhone w 2007 roku, spopularyzowało korzystanie z aplikacji mobilnych i stało się katalizatorem olbrzymiego wzrostu w dziedzinie mobilnej technologii.Technologie chmur obliczeniowych zrewolucjonizowały sposób, w jaki przechowujemy i zarządzamy danymi. Serwery i usługodawcy cloud computing pozwalają na dostęp do zasobów obliczeniowych przez Internet, eliminując potrzebę posiadania wydajnego sprzętu na miejscu. To przejście do modelu infrastruktury jako usługi (IaaS), platformy jako usługi (PaaS) oraz oprogramowania jako usługi (SaaS) przekształciło przemysł IT i umożliwiło skalowanie aplikacji na poziomie globalnym.

Niezwykle istotnym obszarem współczesnej informatyki jest sztuczna inteligencja (AI) i uczenie maszynowe (ML). Techniki AI, takie jak głębokie uczenie (deep learning), znalazły zastosowanie w wielu dziedzinach – od rozpoznawania obrazów i mowy, przez automatyzację zadań, po tworzenie inteligentnych systemów wspomagania decyzji. Rozwój AI otwiera nowe możliwości i wprowadza kolejne wyzwania związane z etyką, bezpieczeństwem i społecznymi implikacjami zaawansowanej technologii.

Internet Rzeczy (IoT) to kolejna kluczowa dziedzina, która przekształca nasze codzienne życie. Dzięki technologii IoT, urządzenia takie jak termostaty, lodówki, systemy bezpieczeństwa, a nawet ubrania, mogą komunikować się ze sobą i z innymi urządzeniami przez Internet, tworząc inteligentne i zintegrowane środowiska.

Ocena nauczyciela:

Ta praca została zatwierdzona przez naszego nauczyciela: 27.09.2024 o 16:28

O nauczycielu: Nauczyciel - Marta G.

Od 13 lat pracuję w szkole średniej i pomagam uczniom oswoić pisanie wypracowań. Uczę, jak planować tekst, dobierać przykłady i formułować tezy pod wymagania matury i egzaminu ósmoklasisty. Buduję na zajęciach spokojny rytm pracy, w którym jest czas na pytania i korektę. Uczniowie często mówią, że dzięki temu czują większą kontrolę nad tekstem i pewność na egzaminie.

Wypracowanie jest bardzo dobrze zorganizowane i szczegółowe.

Komentarze naszych użytkowników:

Oceń:

Zaloguj się aby ocenić pracę.

Zaloguj się